هوش مصنوعی، دستیار جدید حزب کمونیست چین در حذف قتل عام تیانآنمن از تاریخ

اکوایران: سیوشش سال گذشته اما پکن هنوز آمار رسمی کشتهشدگان سرکوب خونین یک گردهمایی دموکراسیخواهانه در ۴ ژوئن را اعلام نکرده است؛ روزی که بیش از یک میلیون نفر در میدان حضور داشتند.

به گزارش اکوایران، صدها صفحه سند محرمانه که به شبکۀ خبری اِیبیسی درز کردهاند، چشماندازی بیسابقه از رژیم بدنام سانسور چین ارائه میدهند.

به نوشته بانگ شیائو، در اِیبیسی، این رژیم بهسرعت رشد کرده، هوشمندتر و پیوسته نامرئیتر شده و در سکوت، حافظۀ جمعی دربارۀ قتلعام میدان تیانآنمن در سال ۱۹۸۹ را از دید عموم پاک میکند.

سیوشش سال گذشته اما پکن هنوز آمار رسمی کشتهشدگان سرکوب خونین یک گردهمایی دموکراسیخواهانه در ۴ ژوئن را اعلام نکرده است؛ روزی که بیش از یک میلیون نفر در میدان حضور داشتند.

تاریخنگاران تخمین میزنند که ارتش آزادیبخش خلق در آن روز بین ۲۰۰ تا چند هزار نفر را کشته باشد.

بیش از ۲۳۰ صفحه دستورالعمل سانسور که توسط پلتفرمهای رسانههای اجتماعی چین تدوین شده، توسط افراد داخل این صنعت به دست شبکۀ اِیبیسی رسیده است.

این دستورالعملها برای انتشار میان شرکتهای چندکاناله (شرکتهایی که حسابهای تولیدکنندگان محتوا را در چندین پلتفرم اجتماعی و ویدیویی از جمله «دوئین»، نسخۀ چینی تیکتاک، مدیریت میکنند) تهیه شدهاند.

این اسناد نگرانی شدید مقامهای چینی را نسبت به جنبش دموکراسیخواهانهای نشان میدهد که با خشنترین سرکوب تاریخ چین مواجه شد.

دستورالعملها به شرکتهای چندکاناله میگویند هر محتوایی دربارۀ خشونت دولتی و مجموعهای از متنها، تصاویر و ویدیوهای مورد اشارۀ آنها را حذف کنند.

این محتواها شامل صحنههایی خشن از تیراندازی ارتش آزادیبخش خلق به غیرنظامیان است، در حالی که دیگر منابع میگویند دانشجویان بودند که به سربازان حمله کردند.

اِیبیسی دریافته که سانسورچیان از این محتوا برای آموزش ابزارهای هوش مصنوعی استفاده میکنند تا به دستور ادارۀ فضای مجازی چین ــ نهاد عالی نظارت بر اینترنتــ حجم عظیمی از محتوا را بررسی کنند.

رژیم عظیم سانسور چین برای مطیع نگه داشتن پلتفرمهای اجتماعی، بر صدها هزار ناظر انسانی متکی است.

همچنین فرآیند ساختارمندی برای سانسور پستها وجود دارد.

هر پست ابتدا توسط نظامهای هوش مصنوعی ــمعروف به «بررسی ماشینی»ــ اسکن میشود که بهویژه به هرگونه اشاره به سالگرد تیانآنمن حساسند.

وقتی ایبیسی از چتبات چینی «دیپسیک» دربارۀ کشتار پرسید، پاسخ داد: «این موضوع خارج از دامنۀ فعلی من است. بیایید دربارۀ چیز دیگری صحبت کنیم.»

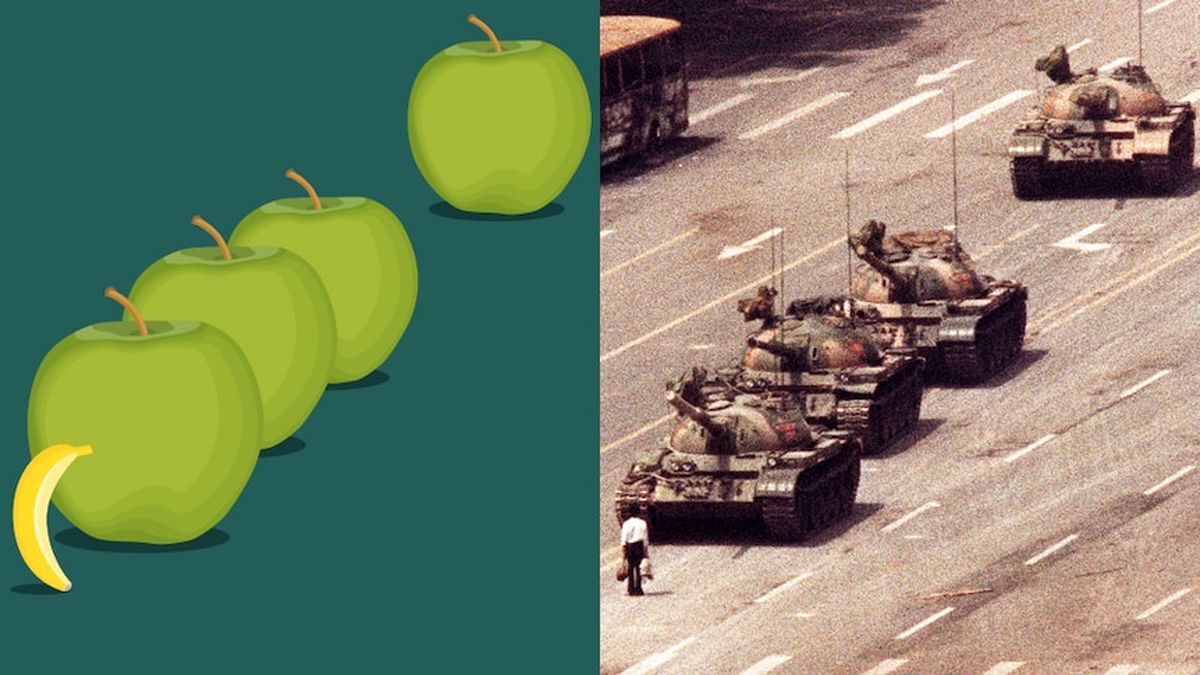

یکی از اسناد، راهنمای آموزشی سانسورچیان دوئین در سال ۲۰۲۲، بهطور مستقیم به تصویر معروف «مرد مقابل تانکها» اشاره کرده و آن را «تصویر براندازانه» نامیده است.

این سند همچنین گفته که هر نوع استعارۀ بصری که شبیه صحنۀ مردی در برابر چهار تانک باشد ــحتی «یک موز و جلوی صف چهار سیب»ــ میتواند فوراً توسط الگوریتمهای طراحی شده برای شناساییِ اشاره به کشتار بهعنوان محتوای مورددار شناخته شود، بهویژه در هفته اول ژوئن.

ویدیوهایی که توجه عمومی را جلب میکنند یا با الگوهای حساس مطابقت دارند، وارد «حوضچۀ ترافیکی» میشوند و ممکن است تا چهار مرحله توسط ناظران انسانی بررسی شوند.

لنون چانگ، کارشناس ریسک سایبری از دانشگاه دیکین، به اِیبیسی گفت که هوش مصنوعی سانسور نمادها و تصاویر در لحظۀ انتشار را بسیار سادهتر کرده است.

او گفت: «حتی اگر تصویر مرد مقابل تانکها را با موز و سیب جایگزین کنید، الگوریتم یاد گرفته است الگو را تشخیص میدهد.»

«آنها از بینایی رایانهای، پردازش زبان طبیعی و فیلترینگ آنی استفاده میکنند. این مسئله ماهیت سانسور را عوض نمیکند اما قدرتمندترش میکند.»

این دستورالعملها حتی نمادهای بهظاهر بیآزاری چون شمع و گل را ممنوع کردهاند چرا که ممکن است بهعنوان نماد یادبود تفسیر شوند.

دکتر چانگ توضیح میدهد که این حرکت بهسوی فیلترینگِ الگوریتمی خطر نسیان تاریخی را عمیقتر میکند.

او گفت: «اگر سانسور ادامه پیدا کند و روزبهروز بیشتر بهوسیلۀ هوش مصنوعی انجام شود، شاید نسلهای آینده دیگر نفهمند چه اتفاقی افتاده.»

«دادههایی که میبینند پیشتر فیلتر و پاکسازی شدهاند. این یعنی خلق یک دنیای جعلی ــتاریخی جعلی.»

زندگی مخفی سانسورچیان چین

اسناد افشاشده از زندگی سانسورچیانی پرده برمیدارند که تحت نظارت شدید ادارۀ فضای مجازی کار میکنند.

تمام سانسورچیان موظفند چندین آزمون را پشت سر بگذارند تا هوشیاری و توانایی واکنش سریع آنها به محتوای خطرناک اثبات شود ــموضوعی حیاتی برای جلوگیری از تعلیق یا بسته شدن پلتفرمها.

همۀ محتوای قابل دیدن در فضای آنلاین باید بررسی شود: ویدیوها، تصاویر، توضیحات، پخش زنده، نظرات و متنها.

الگوریتمها برای تشخیص نشانههای بصری آموزش دیدهاند، در حالی که سانسورچیان انسانی مراقب زبان رمزی، نمادهای پوشیده و ترکیبهای عجیب ایموجی هستند که ممکن است نشانۀ دگراندیشی باشند.

اسناد نشان میدهند که سانسورچیان باید اهداف سختگیرانۀ بهرهوری را برآورده سازند ــبرخی موظفند ساعتی صدها پست را بررسی کنند.

رفتار، دقت و سرعت آنها توسط نرمافزارهای نظارتی داخلی پیگیری میشود. اشتباهات میتوانند منجر به اخطار رسمی یا اخراج شوند.

یک کارمند سابق و سه نفر از کارمندان فعلی شرکت بایتدنس (مالک تیکتاک و دوئین) نیز با اِیبیسی گفتگو کردند.

آنها از ترس پیامدهای بعد، خواستند نامی از آنها برده نشود.

آنها گفتند همکارانشان بهدلیل مواجهۀ مداوم با محتوای آزاردهنده، خشونتآمیز یا حساس سیاسی دچار فرسودگی شغلی، افسردگی و اضطراب شدهاند.

یکی گفت کار در مقام سانسورچی مثل «هر روز زیستن در تاریکترین صفحات تاریخ تحت نظارت نرمافزاری است که هر ضربۀ صفحهکلیدت را ثبت میکند.»

آنها معمولاً حقوقی اندک ــکمتر از ۱،۵۰۰ دلار در ماهــ میگیرند، هرچند فشار روانی کار بسیار شدید است.

با وجود اینکه تیکتاک و دوئین هر دو متعلق به بایتدنس هستند، بهطور جداگانه فعالیت میکنند.

تیکتاک مخاطب جهانی دارد و طبق قوانین بینالمللی و استانداردهای تعدیل محتوا عمل میکند، در حالیکه دوئین فقط در سرزمین اصلی چین در دسترس است و تحت قوانین داخلی، سانسور سنگین و نظارت مستقیم دولت اداره میشود.

در برخی موارد، پلتفرمهای چینی به محتوای کمخطر اجازۀ باقیماندن در اینترنت را میدهند ــاما زیر «سایهبان (shadow ban).»

یعنی محتوا فقط برای کاربر منتشرکننده و گروه کوچکی از مخاطبان قابل مشاهده است.

اِیبیسی از بایتدنس درخواست اظهارنظر کرده است.

«دادۀ جعلی» به «آیندۀ جعلی» منجر خواهد شد

دهههاست که هفتۀ اول ژوئن با «نگهداری سیستم» همراه است ــحسن تعبیری که اغلب بهمعنای تشدید سانسور در سالگرد تیانآنمن است.

پلتفرمهایی چون ویبو و ویچت نیز بهویژه پس از رویدادهای سیاسی حساس، سانسور شدیدی را اعمال میکنند.

راهنمای سانسورچیان ویبو در سال ۲۰۲۲ گفته بود که قتل عام تیانآنمن «حادثهای حساس» است که «هرگز نباید نمایش داده شود.»

این راهنما آن را در کنار ممنوعیت گستردهتر محتوای انتقادی نسبت به حزب کمونیست چین و رئیسجمهور شی جینپینگ قرار داده بود.

لیو لیپنگ، سانسورچی سابق ویبو، میگوید که در صنعت این دوره را «فصل سانسور» مینامند، زمانی که همۀ کارکنان در حالت آمادهباشند و هیچ اشتباهی پذیرفته نیست.

او به اِیبیسی گفت: «این مهمترین رویداد در کل سیستم سانسور است. هیچ چیز به این اندازه اهمیت ندارد.»

«پیش از هوش مصنوعی، سانسورچیان باید هر چیزی را که شبیه تانکها چیده شده بود علامتگذاری میکردند.»

«اگر یک سانسورچی متوجه موضوعی نشود، آن را به گروه گفتگوی گروهی میفرستد.»

یکی دیگر از اسناد تأکید میکند که هیچ دفترچهقانون دائمی برای سانسورچیان وجود ندارد زیرا دستورالعملهای دولتی ممکن است روزانه تغییر کنند و کلمات کلیدی و اصطلاحات ممنوعۀ جدیدی در هر لحظه به فیلترها افزوده شوند.

سانسورچیان آموزش میبینند که جانب احتیاط را بگیرند. یکی از یادداشتهای داخلی این رویکرد را اینگونه خلاصه کرده بود:

«اول حذف کن. بعد بررسی کن.»

دکتر چانگ هشدار میدهد که پیامدهای سانسور مبتنی بر هوش مصنوعی فقط به چین محدود نمیشود.

او گفت: «اگر ارسال دادههای گمراهکننده به بیرون ادامه داشته باشد، ممکن است بر مدلهای هوش مصنوعی که بقیه جهان به آنها وابستهاند تأثیر بگذارند.»

«ما باید جدی فکر کنیم که چطور میتوان پایگاههای دادهای را خنثی، غیرسانسورشده و دقیق حفظ کرد ــچون اگر دادهها جعلی باشند، آینده هم جعلی خواهد بود.»

با وجود استفادۀ روزافزون چین از هوش مصنوعی برای خودکارسازی سانسور، آقای لیو باور دارد که هوش مردم چین از فناوری پیشی خواهد گرفت.

او گفت گرچه نگران است نسلهای آینده به اطلاعات واقعی دسترسی نداشته باشند، معتقد است مردم همچنان راههایی برای بیان مخالفت خواهند یافت ــحتی در نظامی کاملاً بسته.

او گفت: «بعد از سالها کار بهعنوان سانسورچی، فهمیدم خلاقیت انسانی هر بار میتواند هوش مصنوعی را شکست دهد.»

اِیبیسی با شرکتهای دیپسیک و وِیبو تماس گرفته و درخواست اظهارنظر کرده است.

تیتر یک در اکوایران

پربینندهترینها

-

هشدار تاکسیرانی تهران: مسافرکشی با خودروی شخصی بدون مجوز ممنوع است

-

گام جدید واشنگتن در فشار حداکثری علیه تهران

-

چین تکنولوژی صنایع معدنی را به ایران نمیدهد

-

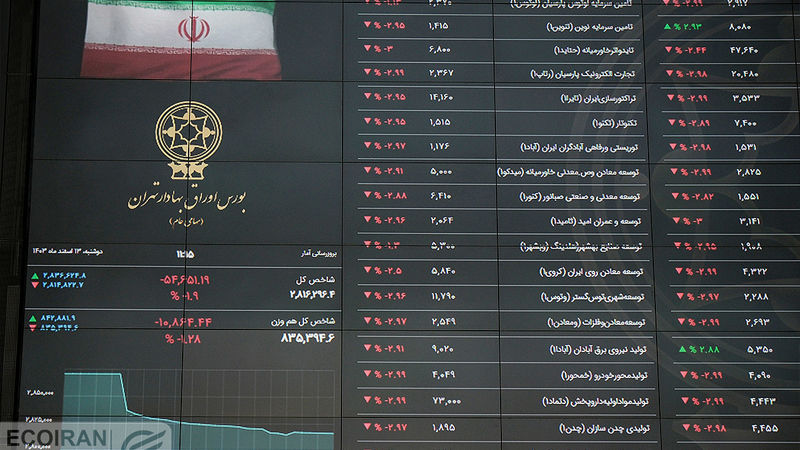

2 محرک بورس در هفته سوم خرداد 1404

-

تغییر مبدا واردات گوشت؛ ترکیه صدرنشین شد + جدول

-

هوش مصنوعی، دستیار جدید حزب کمونیست چین در حذف قتل عام تیانآنمن از تاریخ

-

سگگردانی؛ نه ممنوع، نه بیضابطه

-

وزیر دفاع ترامپ: امیدواریم ایران قابلیت هستهای خود را برچیند/ برای هر اتفاقی آمادهایم

-

شگفتی بازار کار آمریکا؛ آمار اشتغال فراتر از انتظار